Cela fait désormais plusieurs mois que Google a modifié sa façon d'indexer le web et que les SEO rencontrent des problèmes d'indexation sur le moteur de recherche. Non seulement il y a des bugs dans la monstrueuse machine qu'est Google, mais il y a une sorte de filtre de "qualité" qui est encore + sélectif qu'avant. Finalement, on passe beaucoup de temps pour se sortir de situations parfois tordues, même si on finit par trouver comment faire pour ré-indexer un contenu qui est exclu de l'index.

Tout cela implique qu'il est nécessaire de suivre davantage l'indexation de ses pages. La Search Console donne déjà un certain nombre de réponses, même s’il y a de nombreuses incohérences dans les data fournies, il a l'avantage d'être gratuit et de donner un état global de l'indexation de son site. La communauté SEO n'est pas restée les bras croisés : il y a des services à présent pour suivre l'indexation de ses pages, bien pratiques pour les SEO, ou pour suivre en lot et éviter de devoir taper 100 fois la requête site:www.monsite.com/mapagedanstaface si on n'a pas (ou qu'on a des doutes) la Search Console. Il y a également des services pour accélérer l'indexation de vos pages, c'est assez fou de voir comment la communauté s'est organisé pour résoudre ces problèmes d'indexation.

L'analyse de logs

De mon côté, lorsque j'ai créé mon CMS MyStranding, j'avais inclus un système d'analyse de logs de crawl de Google Bot. il n'est pas parfait, mais il me permet de descendre d'une couche et de constater un certain nombre d'agissements dont je n'avais même pas idée avant cela, pourtant ça fait un moment que je fais du web. J'ai, par exemple, été surpris du nombre incroyable de bots divers et variés qui passaient sur mon site.

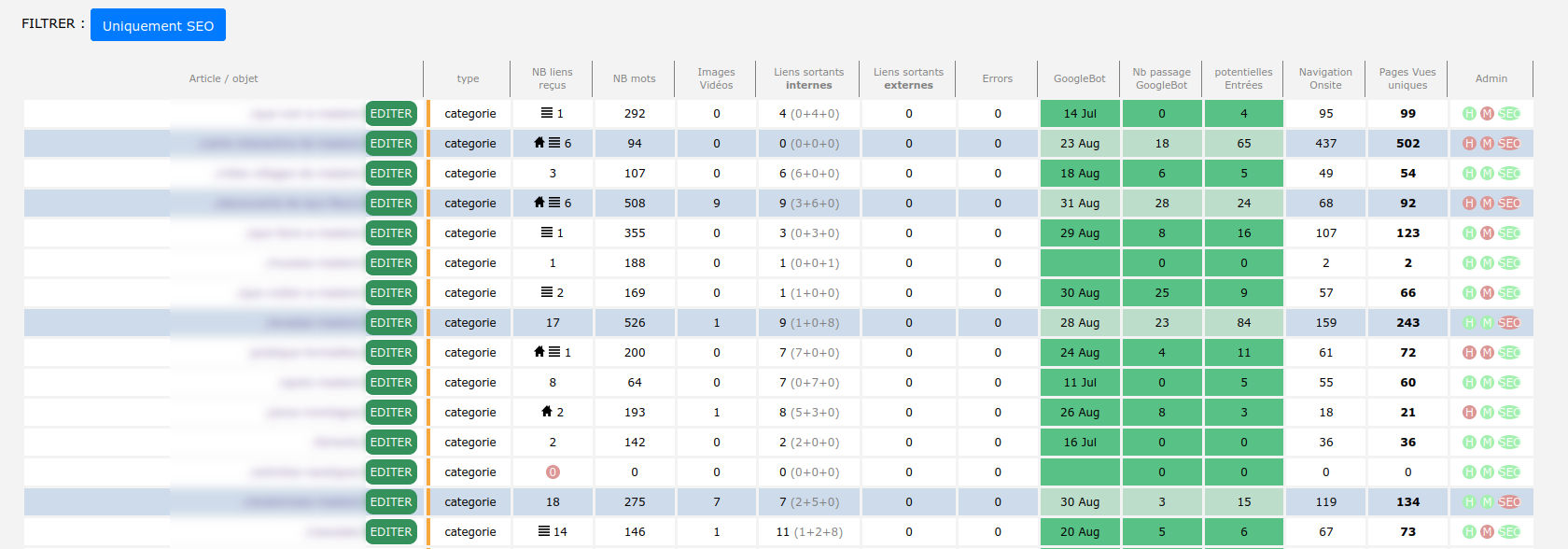

Revenons à nos moutons : à savoir l'analyse de crawl du robot Googlebot sur un site. J'ai décidé d'intégrer cette data (nombre de passages de Googlebot par mois, nombre d'entrées, nombre de pages vues) dans mon outil de suivi de maillage interne. Ça va me permettre de compléter mon tableau de suivi et peut être de croiser des données.

Le contexte

Pour fournir les éléments ci-dessous, je m'appuie sur l'un des sites que j'ai sortis l'an dernier : Je suis parti de 0, avec un NDD neuf acheté en juin 2020. Le site a été réellement publié en septembre 2020. Il y avait entre 50 et 70 pages au démarrage. Il en contient désormais 130. J'ai fait très peu de netlinking, budget 0 oblige. Quelques liens gratuits : annuaires, commentaires de blogs, et quelques opportunités histoire de pas être à 0.

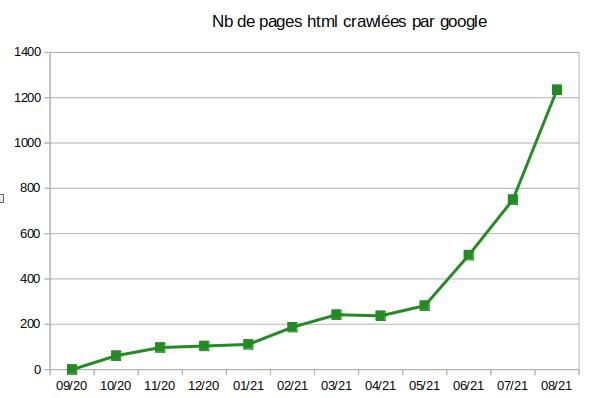

Je n'ai pas encore ajouté la fonction Visu sur le back-office, donc j'ai extrait la data et je suis tout bêtement passé par Excel pour proposer le graphique ci-dessous. Je constate déjà que tant que le site n'a pas eu 1 an, le crawler passe quelques fois par-ci par là et s'en fout un peu de mon site.

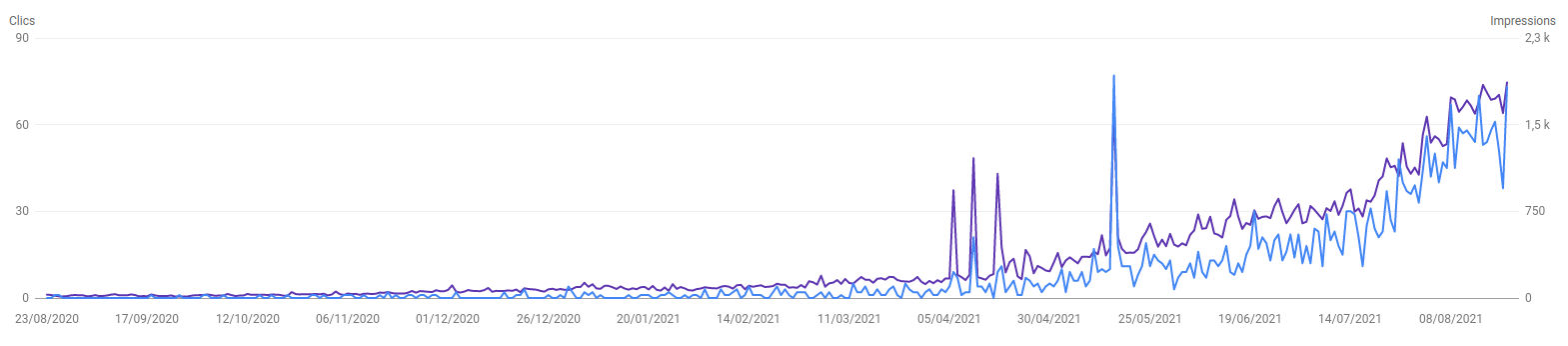

Ce qui est assez intéressant, c'est que la courbe du trafic suit à peu près la même tendance que la courbe de crawl :

Quand j'ai débuté dans le web il y a 20 ans, on parlait beaucoup de la sandbox. Visiblement ça existe toujours : le 6 juin 2021, Google a accéléré le nombre de crawls par jour exactement le jour même de l'anniversaire du NDD. Peut-être que si j'avais travaillé le netlinking avec des backlink j'aurais pu recevoir la confiance de Google un peu avant ? En tout cas je savais très bien qu'il fallait que je sois armé de patience avant de faire un peu de trafic et ça ne m'a jamais découragé.

Quant à la courbe de trafic en elle-même, j'y reviendrai dans un autre article, je pense que j'aurai pu mieux faire les choses. Les 40-60 premières pages du site ne sont vraiment pas bonnes. J'étais trop dans l'esprit technique, sémantique et maillage interne. J'ai fait ce que j'appelle de la bouillie sémantique. Les 30 pages suivantes ont été lancées courant de l'hiver. J'étais + naturel dans l'écriture et moins bourrin dans le maillage interne, et surtout j'ai commencé à travailler avec mon propre outil de sémantique. Ce n'est qu'au mois de mars que j'ai commencé à faire un tout petit peu de trafic. Fort de mes premiers résultats, j'ai continué sur ma lancée et aujourd'hui j'ai beaucoup + d'automatismes.

Les courbes de trafic et de crawl se ressemblent, il y a évidemment une corrélation, je reste cependant persuadé que j'aurai pu faire + de trafic bien avant. Voyons maintenant ce que me raconte mon outil de backoffice S.E.O. Stranding couplé avec la data de crawl de Google & de visites du site.

Le robot d'exploration principal

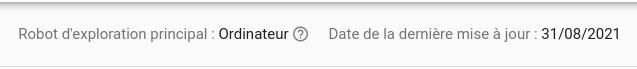

Je fais une petite parenthèse sur ce sujet, parce que c'est quelque chose qui m'agace. Mon site est full mobile friendly, atteint des scores superbes dans lighthouse et autres outils de test responsive & vitesse. Et pourtant Google continue dans la search console de marquer :

En mars : 132 crawl mobile versus 86 crawl ordinateur

En aout : 595 crawl mobile versus 595 crawl ordinateur.

Les deux robots font jeu égal. Pourtant, Google avait fait des annonces fortes pour dire que l'index mobile ferait foi au printemps. J'ai d'autres sites qui ont bien le robot mobile en robot d'exploration principal. D'où est-ce que ça vient ? Aucune idée, mais ça ne flatte pas mon ego. Pour le reste, ça n'a pas l'air d'avoir un impact supplémentaire. À noter que dans l'analyse ci-dessous et dans le tableau, je ne distingue pas le robot de crawl. Mobile & Destkop sont mélangés.

Analyse du dernier mois du crawl : août 2021.

Le mois d'août est celui qui dispose le + de data, je vais me concentrer dessus même si j'ai regardé d'autres mois qui confirment mes hypothèses. GoogleBot a réalisé 1235 crawls de pages html sur le site. J'ai environ 129 pages publiées. On pourrait croire que le bot est passé environ 10 fois sur chaque page. Il n'en est rien.

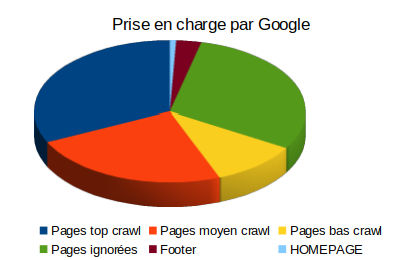

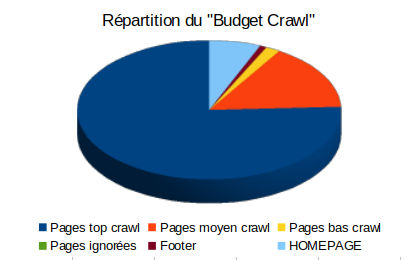

Sur le 1er graphique, on se rend rapidement compte que Google ne s'intéresse qu'à 55% de mon site. Le reste est quasi ou complètement ignoré, soit presque 55 pages sur un total de 130. J'assume, j'ai vraiment balbutié à mes débuts en termes de qualité de contenu. Sur le second graphique, on constate également que quasiment 75% des crawls s'effectuent sur robot s'effectue sur les 43 pages "top page crawl". Ça montre vraiment que le robot n'agit pas de manière uniforme.

Je n'aime pas parler de budget de crawl. Ça n'a pas réellement de sens. En tout cas j'ai le sentiment que les pages bidons sont ignorées et mises de côté naturellement. Faut-il les supprimer pour indiquer à Google qu'on a amélioré la qualité du site ? Les retravailler ?

Si on jette un coup d'œil sur ces 2 graphiques. Le 1er, ce sont les "entrées du site". Du côté "Sources d'entrées", tout est mélangé, mais je fais peu de réseaux sociaux, Bing et autres robots sont très légers en trafic. Bref il y a 85% voire 90% de trafic provenant de Google là-dedans (Mon outil de statistique n'est pas assez poussé pour distinguer correctement la source de trafic). En tout cas, on voit bien que les "top pages crawlées" et la home amènent quasiment tout le trafic. Les pages "peu ou pas crawlées" amènent moins de 5% du trafic. D'où vient ce léger trafic ? Sans doute des réseaux sociaux, de Bing ? C'est intéressant de voir aussi que les pages "moyennement crawlées" apportent peu de trafic, moins de 10%.

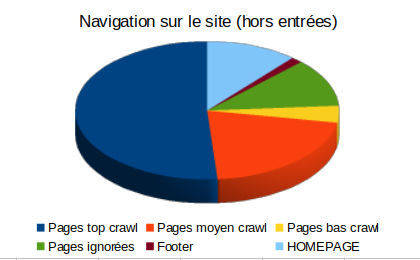

Le dernier graphique montre le nombre de pages vues en fonction du type de pages, hors pages d'entrées. En gros, où va le visiteur au 2ème clic de la visite. Ce qui est étonnant, c'est que les pages ignorées par Google sont assez visitées. Par contre, les pages "peu crawlées" reçoivent peu de visites. Bref, c'est un autre sujet davantage tourné vers l'UX, mais ça montre que les pages créées ne sont pas inutiles. En tout cas, point de suppression pure et simple des pages juste parce que Google a décidé que la page était à exclure de son index !

Toujours sur ce dernier graphique, on voit que 50% des pages vues hors pages d'entrées sont des "top crawlées" de Google. Je n'ai pas regardé dans le détail, mais ce sont sans doute des pages que j'ai bien mis en avant dans le maillage interne et l'UX.

Comment le crawl a évolué au fil des mois sur le site :

- Concernant les pages ignorées et non indexées, je retrouve les mêmes depuis des mois. Ce sont les pages créées en début de projet.

- 31 pages ne sont crawlé que 3 à 9 fois par mois. Cela représente 15% du "budget crawl" du site. Pour moi il y a clairement un problème sur ces pages et elles doivent également attirer mon attention. Elles ne sont pas exclues, mais semblent ne répondre à aucune intention de recherche. Peut-être qu'il faudrait que je retravaille les sujets. Dans l'idée, plutôt que de dire "Parking Puy-en-Velay", il faudrait tout simplement changer d'approcher et dire "Où se garer au Puy-en-Velay".

- 14 pages ne sont crawlé que 1 à 2 fois par mois. Ce sont des pages qui n'ont que peu d'intérêt pour moi aussi. On verra ce qu'on en fait plus tard.

- La homepage est toujours la page la plus crawlée du site. Si on a du nouveau contenu à pousser, il ne faut pas se gêner.

- Le footer est toujours crawlé un minimum, entre 2 et 5 passages par mois par page et représente désormais moins de 1% du total du crawl du site. On parle depuis plusieurs mois du "surfeur raisonnable", c'est selon moi quelque chose qui existe depuis bien longtemps. En tout cas, j'avais créé un footer minimaliste, je vais peut-être l'améliorer en proposant soit un Top article, ou avec des entrées différentes du menu header. L'idée n'est pas de pousser des pages car le signal envoyé semble faible, mais d'apporter un plus pour l'internaute.

La suite :

Cette petite étude m'a poussé à m'interroger sur la transmission de PageRank. C'est un vrai sujet à part entière qui doit demander beaucoup d'énergie pour essayer de calculer le jus qui est transmis ou non, surtout que finalement on n'est pas toujours sûr de ce que fait google : la Search Console est assez brouillonne et ne donne pas toutes les données.

Maintenant que j'ai ajouté à l'outil interne "Linking" la data de crawl de Googlebot, j'ai dans l'idée de rajouter un outil de visualisation de la structure du site directement dans le backoffice de MyStranding, avec des éléments qui permettraient d'imaginer si la page qui transmet le jus est puissante ou non. Il va également falloir que je trouve des solutions pour ma 40aine de page qui est ignoré. Il y a dans cette liste quelques pages qui pourraient ramener du trafic et c'est dommage de s'en passer.

Je vais également m'atteler à corriger les pages ignorées et les pages peu crawlées. Comme je le disais en début d'article, seules 55% des pages répondent à une attente de Google, c'est peu. Je vais commencer par retravailler les pages peu crawlées. Pour moi, c’est un problème d'intention, le sujet de la page a été mal formulé. Ensuite je vais m'attaquer aux pages ignorées par Google. Le contenu n'est pas bon, mais il y a d'autres problèmes d'architecture, que l'outil de visualisation va d'ailleurs mettre en avant assez rapidement.

En parallèle de cela, je me sers désormais de mon outil de suivi de crawl pour indexer mes nouveaux contenus. J'ai remarqué que le PageRank était un critère fort d'indexation : ça me permet d'indexer mes nouvelles pages sans aucun problème.